Studium przypadku: Moderowanie treści

Ponad 30 XNUMX dokumentów internetowych usuniętych i opatrzonych adnotacjami do moderacji treści

które starają się zabezpieczyć przestrzeń online, w której się łączymy i komunikujemy.

Ponieważ korzystanie z mediów społecznościowych stale rośnie,

pojawił się problem cyberprzemocy

istotną przeszkodą dla platform, które do tego dążą

zapewnić bezpieczną przestrzeń online. Zdumiewające

Styka się z tym 38% osób

codzienne szkodliwe zachowanie,

podkreślając pilne zapotrzebowanie na wynalazczość

podejścia do moderacji treści.

Dzisiejsze organizacje polegają na użyciu

sztuczna inteligencja, aby zająć się trwałymi

proaktywne podejście do problemu cyberprzemocy.

Bezpieczeństwo cybernetyczne:

Ujawniono raport Facebooka dotyczący egzekwowania standardów społeczności w czwartym kwartale — działania wobec 4 mln treści związanych z zastraszaniem i nękaniem, przy wskaźniku proaktywnej wykrywalności wynoszącym 6.3%

Wykształcenie:

A 2021 badanie wykazało, że 36.5%% uczniów w Stanach Zjednoczonych w wieku od 12 & 17 lat doświadczyło cyberprzemocy w którymś momencie swojej nauki.

Według raportu z 2020 r. światowy rynek rozwiązań do moderacji treści był wyceniony na 4.07 mld USD w 2019 r. i miał osiągnąć 11.94 mld USD do 2027 r., przy CAGR na poziomie 14.7%.

Rozwiązanie dla świata rzeczywistego

Dane, które moderują globalne konwersacje

Klient rozwijał solidną automatyzację

moderacja treści Machine Learning

model dla swojej oferty w chmurze, dla której oni

szukali dostawcy konkretnej domeny, który

może pomóc im w uzyskaniu dokładnych danych treningowych.

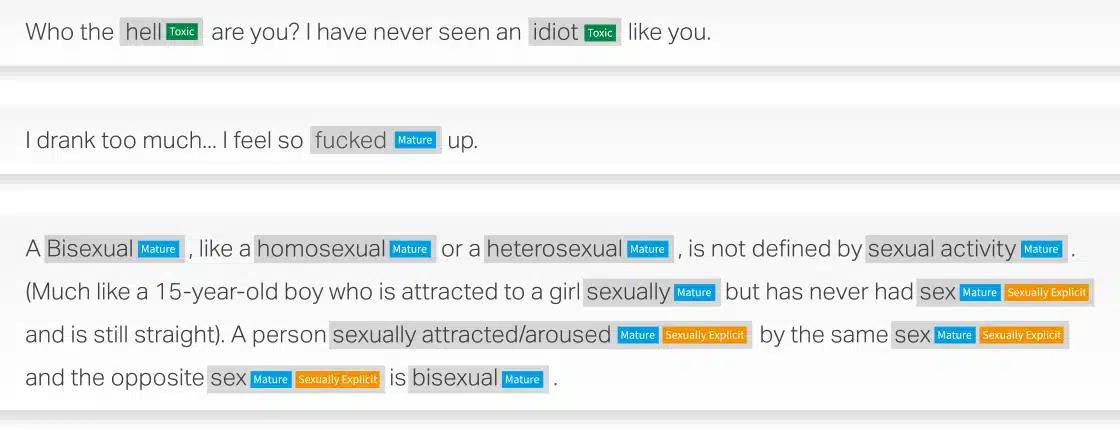

Wykorzystując naszą rozległą wiedzę w zakresie przetwarzania języka naturalnego (NLP), pomogliśmy klientowi zebrać, skategoryzować i dodać adnotacje do ponad 30,000 XNUMX dokumentów w języku angielskim i hiszpańskim, aby zbudować automatyczną moderację treści Model uczenia maszynowego podzielony na treści toksyczne, dla dorosłych lub o charakterze jednoznacznie seksualnym kategorie.

Problem

- Przeszukanie sieci 30,000 XNUMX dokumentów w języku hiszpańskim i angielskim z domen o priorytecie

- Kategoryzowanie zebranych treści na krótkie, średnie i długie segmenty

- Oznaczanie skompilowanych danych jako treści toksycznych, dla dorosłych lub o charakterze jednoznacznie seksualnym

- Zapewnienie wysokiej jakości adnotacji z dokładnością co najmniej 90%.

Rozwiązanie

- Web Scrapped 30,000 XNUMX dokumentów dla każdego języka hiszpańskiego i angielskiego z BFSI, opieki zdrowotnej, produkcji, handlu detalicznego. Treść została dodatkowo podzielona na krótkie, średnie i długie dokumenty

- Pomyślne oznaczenie treści jako treści toksyczne, dla dorosłych lub o charakterze jednoznacznie seksualnym

- Aby osiągnąć 90% jakości, Shaip wdrożył dwupoziomowy proces kontroli jakości:

» Poziom 1: Kontrola jakości: 100% plików do zatwierdzenia.

» Poziom 2: Kontrola krytycznej analizy jakości: zespół CQA firmy Shaips ocenia 15%-20% próbek retrospektywnych.

Wynik

Dane szkoleniowe pomogły w zbudowaniu modelu ML automatycznego moderowania treści, który może przynieść kilka wyników korzystnych dla utrzymania bezpieczniejszego środowiska online. Niektóre z kluczowych wyników obejmują:

- Wydajność przetwarzania ogromnej ilości danych

- Konsekwencja w zapewnieniu jednolitego egzekwowania zasad moderacji

- Skalowalność umożliwiająca dostosowanie do rosnącej bazy użytkowników i ilości treści

- Moderacja w czasie rzeczywistym może zidentyfikować i

usuwać potencjalnie szkodliwe treści w miarę ich generowania - Opłacalność dzięki ograniczeniu zależności od ludzkich moderatorów

Przykłady moderacji treści

Powiedz nam, jak możemy pomóc w Twojej następnej inicjatywie AI.