W rozwijającej się dziedzinie sztucznej inteligencji (AI) skupienie się na względach etycznych i uczciwości to coś więcej niż imperatyw moralny — to fundamentalna konieczność zapewniająca trwałość technologii i akceptację społeczną. Etyczna sztuczna inteligencja, czyli uczciwa sztuczna inteligencja, polega na zapewnieniu, że systemy sztucznej inteligencji działają bez uprzedzeń, dyskryminacji i niesprawiedliwych skutków. Na tym blogu badamy znaczenie etycznej sztucznej inteligencji i zagłębiamy się w różne rodzaje uprzedzeń, których należy unikać.

Dlaczego etyczna sztuczna inteligencja ma znaczenie

Systemy sztucznej inteligencji w coraz większym stopniu stają się częścią naszego codziennego życia, podejmując decyzje mające wpływ na wszystko, od wniosków o pracę po wyroki sądowe. Kiedy systemy te są stronnicze, mogą utrwalić i pogłębić nierówności społeczne, wyrządzając szkody jednostkom i grupom. Etyczna sztuczna inteligencja ma na celu zapobieganie takim skutkom poprzez promowanie uczciwości, odpowiedzialności, przejrzystości i poszanowania praw człowieka.

Rodzaje uprzedzeń i przykłady

Stronniczość przemocy

Systemy sztucznej inteligencji muszą zostać przeszkolone w zakresie rozpoznawania i pomijania treści zawierających przemoc. Na przykład model językowy wyszkolony na brutalnym tekście może generować szkodliwe treści, promując agresję zamiast konstruktywnego dialogu.

Kontrowersyjne tematy

Szkolenie sztucznej inteligencji w zakresie kontrowersyjnych tematów bez ostrożnego umiaru może doprowadzić do przyjęcia przez sztuczną inteligencję spolaryzowanego stanowiska. Na przykład sztuczna inteligencja przeszkolona w zakresie danych na temat praw do posiadania broni może generować kontrowersyjne i jednostronne argumenty.

Uprzedzenie wobec płci

Klasycznym przykładem uprzedzeń związanych z płcią jest sytuacja, w której model językowy kojarzy pielęgniarki z kobietami, a inżynierów z mężczyznami, co raczej wzmacnia przestarzałe stereotypy niż odzwierciedla różnorodność tych zawodów.

Uprzedzenia rasowe i etniczne

Rozważmy sztuczną inteligencję, która generuje obrazy dyrektorów generalnych, ale przedstawia ich głównie jako należących do jednej grupy rasowej, ignorując w ten sposób rzeczywistość różnorodności w świecie korporacji.

Stronniczość społeczno-ekonomiczna

Systemy sztucznej inteligencji mogą faworyzować język lub koncepcje związane z wyższym statusem społeczno-ekonomicznym, na przykład zakładanie, że marki luksusowe są standardem jakości, pomijając szersze spektrum doświadczeń konsumentów.

Stronniczość wiekowa

Sztuczna inteligencja może błędnie założyć, że odniesienia do technologii nie dotyczą osób starszych, wykluczając je w ten sposób z rozmów na temat postępu cyfrowego.

Uprzedzenie kulturowe

System AI może generować recenzje restauracji skupiające się na kuchniach zachodnich, pomijając bogactwo innych tradycji kulinarnych i tym samym marginalizując kultury niezachodnie.

Stronniczość polityczna

Sztuczna inteligencja zaprogramowana do wybierania artykułów prasowych może nieproporcjonalnie wybierać artykuły z lewego lub prawego krańca spektrum politycznego, zamiast prezentować zrównoważone poglądy.

Uprzedzenia religijne

Jeśli system sztucznej inteligencji w nieproporcjonalny sposób odnosi się do jednej religii w pozytywnym świetle, ignorując lub fałszywie przedstawiając inne, wykazuje stronniczość religijną.

Regionalne uprzedzenia

Model językowy może generować raporty o ruchu drogowym, które są istotne tylko dla obszarów miejskich, z widokiem na regiony wiejskie lub mniej zaludnione.

Skłonność do niepełnosprawności

Weź pod uwagę doradcę ds. zdrowia AI, który nie zapewnia dostępnych opcji ćwiczeń dla osób niepełnosprawnych, oferując w ten sposób niekompletne i wykluczające porady.

Błędy językowe

Sztuczna inteligencja tłumaczeniowa może konsekwentnie dostarczać tłumaczenia wysokiej jakości w przypadku niektórych języków, ale kiepskiej jakości w przypadku języków mniej reprezentowanych w jej danych szkoleniowych.

Odchylenie od potwierdzenia

Sztuczna inteligencja może wzmocnić wiarę użytkownika w fałszywy lek poprzez selektywne odwoływanie się do źródeł potwierdzających ten lek i ignorowanie konsensusu naukowego.

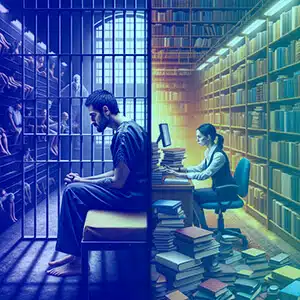

Stronniczość kontekstowa

Sztuczna inteligencja może interpretować prośby o informacje na temat „więzień” jako dochodzenie karne, a nie akademickie lub prawne, w zależności od kontekstu, w jakim została przeszkolona.

Stronniczość źródła danych

Jeśli dane szkoleniowe sztucznej inteligencji pochodzą z forum, na którym omawiane są głównie osiągnięcia określonej grupy demograficznej, może ona pominąć wkład innych grup.

Jak uniknąć tych uprzedzeń

Unikanie tych uprzedzeń wymaga wieloaspektowego podejścia:

- Zróżnicowane zestawy danych: Uwzględnij szeroką gamę źródeł danych, aby zrównoważyć reprezentację w różnych grupach.

- Regularny audyt: Wykonuj ciągłe kontrole, aby identyfikować i korygować uprzedzenia.

- Przejrzystość: Wyjaśnij, w jaki sposób systemy AI podejmują decyzje i na jakich danych są szkolone.

- Integracja w zespołach AI: Zróżnicowane zespoły mogą lepiej identyfikować potencjalne błędy systematyczne, które można przeoczyć.

- Szkolenie z etyki: Edukuj twórców sztucznej inteligencji na temat znaczenia względów etycznych.

- Informacje zwrotne od zainteresowanych stron: Zaangażuj użytkowników i społeczności, których to dotyczy, w proces rozwoju sztucznej inteligencji.

Dlaczego Shaip

Shaip, jako lider rozwiązań w zakresie danych AI, oferuje kompleksowe usługi mające na celu bezpośrednie zwalczanie uprzedzeń związanych ze sztuczną inteligencją. Zapewniając różnorodne i zrównoważone zbiory danych do szkolenia modeli sztucznej inteligencji, Shaip gwarantuje, że Twoje systemy sztucznej inteligencji będą narażone na szerokie spektrum ludzkich doświadczeń i demografii, zmniejszając ryzyko uprzedzeń na wszystkich frontach – od płci i rasy po język i niepełnosprawność. Ich rygorystyczne procesy przechowywania danych i adnotacji w połączeniu z etycznymi ramami sztucznej inteligencji mogą pomóc organizacjom identyfikować, łagodzić i zapobiegać włączaniu błędów do systemów sztucznej inteligencji. Doświadczenie firmy Shaip w opracowywaniu niestandardowych modeli oznacza również, że może ona pomóc w tworzeniu sztucznej inteligencji, która będzie możliwie włączająca, uczciwa i bezstronna, zgodnie z globalnymi standardami etycznej sztucznej inteligencji.

Wnioski

Etyczna sztuczna inteligencja ma kluczowe znaczenie dla stworzenia przyszłości, w której technologia będzie służyć ludzkości bez uprzedzeń. Rozumiejąc i łagodząc uprzedzenia, programiści i zainteresowane strony mogą zapewnić, że systemy sztucznej inteligencji będą uczciwe i sprawiedliwe. Odpowiedzialność za stworzenie środowiska, w którym technologia odzwierciedla nasze najwyższe standardy etyczne, a tym samym promuje sprawiedliwe i włączające społeczeństwo, spoczywa na wszystkich osobach zaangażowanych w cykl życia sztucznej inteligencji. Dzięki czujności i oddaniu tym zasadom sztuczna inteligencja może osiągnąć swój prawdziwy potencjał jako siła działająca na rzecz dobra.