Cyfrowy świat nieustannie ewoluuje, a jednym z katalizatorów, który odróżnia tę platformę od innych, jest: Materiał generowany przez użytkowników. Chociaż firmy na całym świecie mają swoje strony internetowe i dedykowaną obecność w mediach społecznościowych, użytkownicy są bardziej skłonni ufać opiniom swoich kolegów klientów niż kierować się słowami firmy.

Ponad 4.26 miliard osób byli aktywnymi użytkownikami mediów społecznościowych w 2021 r. Przewiduje się, że do 6 r. liczba ta osiągnie 2027 miliardów. Ilość treści wygenerowanych, przechwyconych, udostępnionych i konsumowanych w skali globalnej wyniosła 64.2 zetabajtów w 2020 r.

Ponieważ nowe treści są generowane i konsumowane w oszałamiającym tempie, ważne stało się, aby marki miały oko na treści hostowane na ich platformach. Platformy internetowe powinny być i pozostawać bezpiecznym środowiskiem dla swoich użytkowników.

[Przeczytaj także: Zrozumienie automatycznej moderacji treści]

Co to jest moderacja treści i dlaczego?

Treści generowane przez użytkowników napędzają platformy mediów społecznościowych i moderacja treści odnosi się do sprawdzania tych treści pod kątem nieodpowiednich lub obraźliwych postów. Platformy biznesowe i społecznościowe mają określony standard monitorowania treści hostingu.

Wytyczne mogą obejmować wszystko, od przemocy, ekstremizmu, mowy nienawiści, nagość, naruszenie praw autorskich lub cokolwiek obraźliwego. Opublikowana treść zostanie oznaczona i usunięta, jeśli nie spełnia standardów.

Ideą moderacji treści jest upewnienie się, że treść jest zgodna z ideałami marki i podtrzymuje wartości przyzwoitości, zaufania i bezpieczeństwa.

Moderacja treści ma kluczowe znaczenie dla firm, aby utrzymać standardy biznesowe, wizerunek marki, reputację i wiarygodność. W każdej sekundzie oszałamiająca ilość treści generowanych przez użytkowników publikowanych na platformach utrudnia markom trzymanie się z dala od obraźliwych i niewłaściwa zawartość, tekst, filmy i obrazy. Strategia moderacji treści pomaga markom zachować ich wizerunek, jednocześnie umożliwiając użytkownikom wyrażanie siebie i zamykając obraźliwe, wulgarne i brutalne treści.

Jakie typy treści możesz moderować?

Algorytmy moderowania treści zwykle zajmują się trzema lub kombinacją tych typów treści.

Tekst

Sama ilość tekstu – od komentarzy po pełnowymiarowe artykuły – która wymaga moderacji, jest oszałamiająca. Posty tekstowe są dostępne niemal wszędzie w formie komentarzy, artykułów, postów na forum, dyskusji w mediach społecznościowych i innych wpisów.

Algorytmy moderowania treści tekstowych powinny być w stanie skanować tekst o różnych długościach i stylach w poszukiwaniu niechcianej treści. Co więcej, moderacja tekstu może być trudnym zadaniem ze względu na złożoność języka i niuanse kulturowe.

Obrazy

Moderacja obrazu jest znacznie prostsza niż moderacja tekstu, ale niezbędne jest posiadanie odpowiednich wytycznych lub standardów.

Ponadto, ponieważ podczas moderowania obrazów mogą wchodzić w grę różnice kulturowe, ważne jest, aby dokładnie zrozumieć społeczność użytkowników w kilku lokalizacjach geograficznych i połączyć się z nimi.

Filmy

Moderowanie treści wideo jest bardzo trudne, ponieważ moderowanie filmów może być czasochłonne, w przeciwieństwie do tekstu lub obrazów. Moderator musi obejrzeć cały film przed uznaniem go za nadający się lub niezdatny do spożycia. Nawet jeśli tylko kilka klatek w filmie jest wyraźnych lub niepokojących, zmusi to moderatora do usunięcia całej treści.

Przekaz na żywo

Transmisje na żywo to prawdopodobnie najtrudniejsza treść do moderowania. Dzieje się tak dlatego, że moderacja wideo i towarzyszącego mu tekstu musi odbywać się jednocześnie z transmisją strumieniową.

Jak działa moderacja treści?

Aby rozpocząć moderowanie treści na swojej platformie, powinieneś najpierw wprowadzić standardy lub wytyczne, które określają nieodpowiednie treści. Te wytyczne pomagają moderatorom zgłaszać treści do usunięcia.

Zdefiniuj poziom wrażliwości lub próg, który moderatorzy treści powinni wziąć pod uwagę podczas przeglądania treści. Próg należy określić na podstawie marki, rodzaju działalności, oczekiwań użytkowników i lokalizacji.

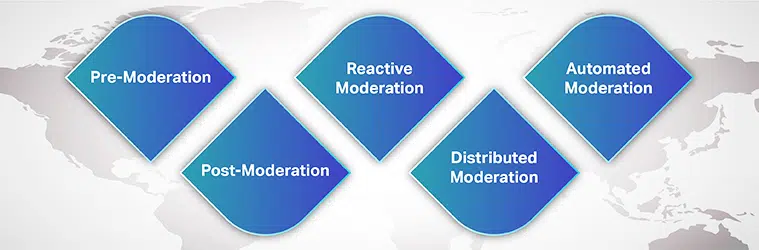

Rodzaje moderacji treści

Możesz wybierać spośród wielu moderacja procesów dla potrzeb Twojej marki i zgoda użytkownika. Niektórzy z nich są:

Wstępna moderacja

Zanim treść zostanie wyświetlona w Twojej witrynie, czeka ona w kolejce do moderacji. Dopiero po przejrzeniu treści i uznaniu jej za zdatną do spożycia jest ona publikowana na platformie. Chociaż jest to bezpieczna metoda blokowania treści dla dorosłych, jest czasochłonna.

Po moderacji

Postmoderacja to standardowa metoda moderacji treści, w której istnieje kompromis między zaangażowaniem użytkownika a moderacją. Chociaż użytkownicy mogą publikować swoje zgłoszenia, nadal są one umieszczane w kolejce do moderacji. Jeśli treść została oznaczona, jest sprawdzana i usuwana. Firmy starają się skrócić czas sprawdzania, aby nieodpowiednie treści nie pozostawały zbyt długo online.

Moderacja reaktywna

W moderacji reaktywnej społeczność użytkowników jest zachęcana do oznaczania nieodpowiednich treści, które naruszają społeczność zasady i wytyczne. W tej metodzie uwagę społeczności zwraca się na treści wymagające moderacji. Jednak obraźliwe treści mogą pozostać na platformie przez dłuższy czas.

Rozproszona moderacja

W rozproszonej metodzie moderacji społeczność internetowa może przeglądać, oznaczać i usuwać treści, które uznają za obraźliwe i sprzeczne z wytycznymi, korzystając z systemu ocen.

Automatyczna moderacja

Jak sama nazwa wskazuje, automatyczna moderacja wykorzystuje różne narzędzia i systemy do oznaczania słów lub fraz oraz odrzucania zgłoszeń. Działa poprzez filtrowanie niektórych zabronionych słów, obrazów i filmów za pomocą algorytmów uczenia maszynowego.

Chociaż moderacja oparta na technologii staje się powszechna, ludzki umiar w przeglądzie nie może być zignorowany. Firmy najlepiej stosują połączenie zautomatyzowanych narzędzi i ludzkich moderatorów, przynajmniej w złożonych sytuacjach.

[Przeczytaj także: Studium przypadku – moderacja treści]

W jaki sposób uczenie maszynowe pomaga w moderacji treści?

Przy ponad 5 miliardach ludzi korzystających z Internetu i ponad 4 miliardach aktywnych w sieciach społecznościowych nie jest łatwo zdziwić się samą liczbą obrazów, tekstów, filmów, postów i wiadomości generowanych codziennie. Te gigantyczne treści muszą być w jakiś sposób moderowane, aby użytkownicy korzystający z ich serwisów społecznościowych mogli cieszyć się przyjemnym i wzbogacającym doświadczeniem.

Moderacja treści powstała jako rozwiązanie do usuwania treści, które są wulgarne, obraźliwe, obraźliwe, oszukańcze lub sprzeczne z etosem marki. Tradycyjnie firmy polegały wyłącznie na ludzkich moderatorach w celu przeglądania treści generowanych przez użytkowników online publikowanych na ich platformach. Jednak całkowite uzależnienie od moderatorów ludzkich może sprawić, że proces będzie czasochłonny, kosztowny i nieefektywny.

Firmy wykorzystują teraz algorytmy uczenia maszynowego do automatycznego i skutecznego moderowania treści. Zasilany AI moderacja treści sprawiła, że cały proces jest wydajny, szybszy, spójny i opłacalny.

Chociaż ten proces nie eliminuje potrzeby ludzkich moderatorów – człowiek-w-pętli, wkład moderatorów ludzkich pomaga radzić sobie ze złożonymi problemami. Co więcej, moderatorzy ludzcy lepiej rozumieją niuanse językowe, różnice kulturowe i kontekst. Gdy używane są zautomatyzowane narzędzia, z pomocą moderatorów ludzkich, zmniejsza się psychologiczny wpływ narażenia na treści wyzwalające.

Wyzwania związane z moderacją treści

Kolejnym poważnym wyzwaniem, jeśli chodzi o opracowanie dokładnego algorytmu moderacji treści, jest język. Niezawodna aplikacja do moderowania treści powinna być w stanie rozpoznać kilka języków i zrozumieć niuanse kulturowe, konteksty społeczne i dynamikę językową.

Ponieważ język przechodzi kilka zmian w czasie, a niektóre słowa, które były niewinne wczoraj, mogły zyskać dziś rozgłos – model ML musi nadążać za zmieniającym się światem. Na przykład obraz aktu może być wyraźnym i podglądaczem lub po prostu sztuką.

Jak kawałek treści jest postrzegana lub uznana za nieodpowiednią, zależy od kontekstu. Niezbędne jest zachowanie spójności i standardów na platformie, aby użytkownicy mogli zaufać działaniom moderacyjnym.

Typowy użytkownik zawsze próbuje znaleźć luki w twoich wytycznych i ominąć zasady moderacji. Jednak twój algorytm ML powinien być w stanie stale ewoluować wraz ze zmieniającymi się czasami.

Wreszcie jest to kwestia stronniczości. Dywersyfikacja szkoleniowej bazy danych i modeli szkoleniowych w celu wykrycia kontekstu ma kluczowe znaczenie. Chociaż opracowanie niezawodnego algorytmu moderacji treści może wydawać się trudne, zaczyna się od zdobycia wysokiej jakości zestawów danych treningowych.

Dostawcy zewnętrzni posiadający odpowiednią wiedzę i doświadczenie w dostarczaniu odpowiednich zestawów danych szkoleniowych to właściwe miejsca, by zacząć.

Każda firma z obecnością społecznościową potrzebuje przełomu rozwiązanie do moderowania treści który pomaga budować zaufanie klientów i nienaganną obsługę klienta. Aby zbudować aplikację i wyszkolić model uczenia maszynowego, potrzebujesz dostępu do wysokiej jakości bazy danych pozbawionej uprzedzeń, zgodnej z najnowszymi trendami językowymi i charakterystycznymi dla rynku.

Dzięki naszemu wieloletniemu doświadczeniu w pomaganiu firmom we wprowadzaniu modeli AI, Szaip oferuje kompleksowe systemy gromadzenia danych zaspokajające różnorodne potrzeby w zakresie moderacji treści.